Datensätze wachsen rapide – auch weil sie zunehmend durch das informationssensitive Internet of Things (IoT) erfasst werden. Dazu gehören mobile Geräte, Haushaltsgeräte, Antennen (Fernerkundung), Softwareprotokolle, Kameras, Mikrofone, RFID-Lesegeräte und drahtlose Sensornetzwerke. Die technologische Pro-Kopf-Speicherkapazität der Welt hat sich seit den 80er Jahren etwa alle 40 Monate verdoppelt. Deshalb ist Big Data ein zentrales Thema für Politik, Wissenschaft und Unternehmen.

Was ist Big Data?

Der Begriff wird seit den 1990er Jahren verwendet. Big Data sind Datensätze, die so umfangreich und komplex sind, dass herkömmliche Datenverarbeitungssoftware nicht ausreicht, um sie zu verarbeiten. Big Data umfasst unstrukturierte, halbstrukturierte und strukturierte Daten, wobei der Schwerpunkt auf unstrukturierten Daten liegt. Grundsätzlich stellt Big Data die Informationswerte dar, die sich durch ein so hohes Volumen, eine so hohe Geschwindigkeit und Vielfalt auszeichnen, dass sie spezifische Technologien und Analysemethoden für ihre Umwandlung in Wert bzw. verwendbare Informationen erfordern. Die Daten stammen dabei aus unterschiedlichen Bereichen, z.B.:

- Internet

- Mobilfunk

- Finanzindustrie

- Gesundheitswesen

- Verkehrsdaten

- Energiewirtschaft

Zu den großen Herausforderungen zählen dabei die Erfassung der Daten mit speziellen Lösungen, deren Speicherung und deren Analyse. Weitere wertvolle Kompetenzen sind unter anderem die Suche, Nutzung, Übertragung, Visualisierung, Abfrage, Aktualisierung sowie insbesondere der Schutz der Daten.

Die Analyse von Datensätzen kann neue Zusammenhänge finden, um beispielsweise Geschäftstrends zu erkennen oder Konsumentenverhalten zu untersuchen.

Herkunft von Big Data

Die erhobenen Daten stammen aus verschiedenen Bereichen, wie z.B.:

- Transaktionsdaten, z.B. Daten aus Rechnungen, Zahlungsaufträgen, Lager- und Lieferscheinen

- Maschinendaten,B. Daten von Industrieanlagen oder Verkehrsmittel

- Echtzeitdaten von Sensoren (einschließlich Sensoren auf dem Smartphone) und Weblogs, die das Benutzerverhalten online verfolgen

- Soziale Daten, z.B. Daten, die von sozialen Mediendiensten wie Facebook Likes, Tweets und YouTube-Ansichten stammen

- Daten von mobilen Geräten

- Finanzmarktdaten, z.B. Transaktions- und Börsendaten

- Internet der Dinge (IoT)

- Machine to Machine Kommunikation (M2M)

- Multimediadaten – größter Teil des Datenflusses im World Wide Web

- Gesundheitswesen, z.B. Genanalyse

- Wissenschaft, z.B. Klimaforschung, Genetik oder Geologie

und vieles mehr.

In vielen Fällen sind diese Daten für sich genommen bedeutungslos. Ein echter Geschäftswert entsteht oft erst durch die Kombination dieser Big Data-Feeds mit traditionellen (relationalen) Daten wie Kundendaten, Vertriebsstandortdaten und Umsatzzahlen, um neue Erkenntnisse, Entscheidungen und Aktionen zu generieren.

Beispiele für die Verarbeitung großer Datenmengen

Internationale Entwicklung: Untersuchungen zur effektiven Nutzung von Informations- und Kommunikationstechnologien legen nahe, dass verarbeitete Daten wichtige Erkenntnisse liefern, aber auch einzigartige Herausforderungen für die internationale Entwicklung darstellen können. Fortschritte in der Analyse von Big Data bieten eine kostengünstige Möglichkeit zur Verbesserung der Entscheidungsfindung in kritischen Entwicklungsbereichen, wie in der Gesundheitsversorgung, Beschäftigung, wirtschaftlichen Produktivität, Kriminalität, Sicherheit sowie im Naturkatastrophen- und Ressourcenmanagement.

Fertigung: Hier stehen Verbesserungen in der Lieferplanung und Produktqualität im Vordergrund. Big Data ist die Grundlage für die Transparenz in der Fertigungsindustrie, die es ermöglicht, Unsicherheiten wie inkonsistente Komponentenleistung und -verfügbarkeit zu beseitigen. Predictive Manufacturing als anwendbarer Ansatz für nahezu keine Ausfallzeiten und Transparenz erfordert eine große Datenmenge und fortschrittliche Prognosewerkzeuge für eine systematische Verarbeitung von Daten zu nützlichen Informationen. Ein konzeptioneller Rahmen der prädiktiven Fertigung beginnt mit der Datenerfassung, bei der verschiedene Arten von Sensordaten wie Akustik, Vibration, Druck, Strom, Spannung und Reglerdaten erhoben werden können.

Gesundheitswesen: Big Data Analytics ist mitverantwortlich dafür, das Gesundheitswesen zu verbessern, indem es unter anderem personalisierte Medizin und präskriptive Analytik bietet. Der Umfang der in den Gesundheitssystemen generierten Daten ist nicht trivial. Mit dem zusätzlichen Einsatz von mHealth, eHealth und tragbaren Technologien wird das Datenvolumen weiter zunehmen. Dazu gehören unter anderem elektronische Gesundheitsdaten, Bilddaten, Patientendaten und Sensordaten. Die Notwendigkeit, der Daten- und Informationsqualität in solchen Umgebungen mehr Aufmerksamkeit zu schenken, ist noch größer geworden.

Medien: Um zu verstehen, wie die Medien große Datenmengen nutzen, ist es zunächst notwendig, einen Kontext in den Medienprozess zu bringen. Die Branche scheint sich vom traditionellen Ansatz, bestimmte Medienumgebungen wie Zeitungen, Zeitschriften oder Fernsehsendungen zu nutzen, zu entfernen und stattdessen die Verbraucher mit Technologien anzusprechen, die die Zielgruppen zu optimalen Zeiten und an optimalen Orten erreichen. Ziel ist es, eine Botschaft oder einen Inhalt zu vermitteln, der (statistisch gesehen) im Einklang mit der Einstellung des Verbrauchers steht. So werden beispielsweise Botschaften (Anzeigen) und Inhalte (Artikel) zunehmend auf die Bedürfnisse der Konsumenten zugeschnitten, die ausschließlich durch verschiedene Data-Mining-Aktivitäten gewonnen wurden.

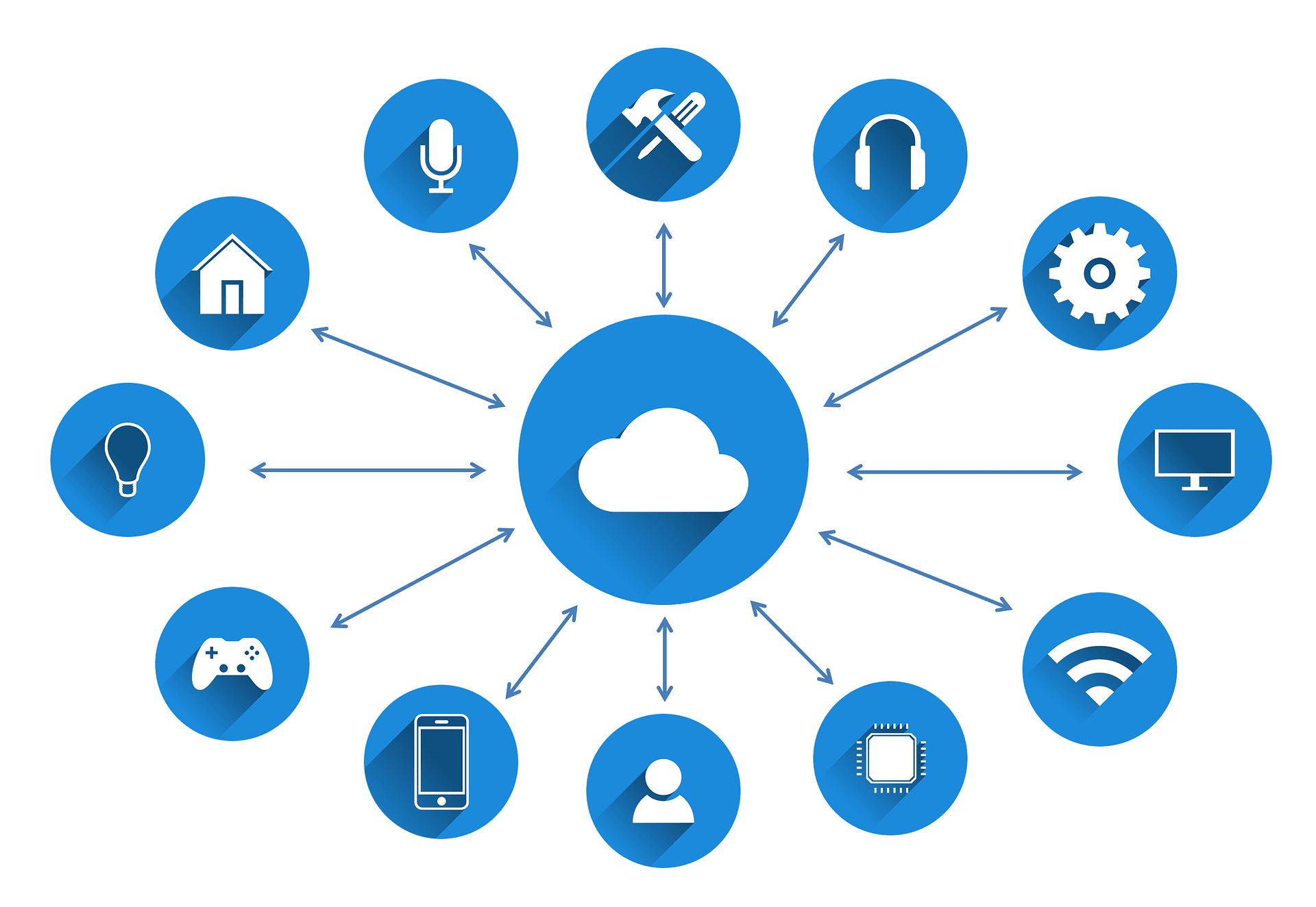

Internet der Dinge (Internet of Things – IoT): Der Grundgedanke vom Internet der Dinge ist es, Gegenstände zu smarten Objekten zu machen, um daraus Daten zu gewinnen. Dabei handelt es sich sowohl um Alltagsgegenstände, wie z.B. Uhren oder Kühlschränke, als auch um Fahrzeuge oder Bahngleise. Diese intelligenten Objekte generieren ständig neue Informationen, die mit Hilfe einer Big Data-Analyse erst ausgewertet und in Erkenntnisse umgewandelt werden können. Aufgrund einer immer größer werdenden Anzahl an vernetzten Geräten werden auch immer mehr Daten gesammelt. Das hat zur Folge, dass die Auswertung der Datenbestände zwar schwieriger wird, jedoch relevantere Schlüsse daraus gezogen werden können.

Herausforderungen von Big Data

Die offensichtlichste Herausforderung, die mit hohen Datenmengen verbunden ist, ist die einfache Speicherung und Analyse dieser Informationen. Dokumente, Fotos, Audio, Videos und andere unstrukturierte Daten können schwierig zu durchsuchen und zu analysieren sein. Um das Datenwachstum zu bewältigen, setzen Unternehmen auf verschiedene Technologien. Wenn es um Storage geht, können konvergierte und hyperkonvertierte Infrastrukturen und softwaredefinierte Speicher die Skalierung der Hardware erleichtern. Natürlich wollen Unternehmen nicht nur Daten speichern, sondern wollen sie nutzen, um ihre Geschäftsziele zu erreichen.

Big Data ist für Unternehmen hilfreich, um wettbewerbsfähiger zu werden – aber nur, wenn sie daraus Erkenntnisse gewinnen und diese schnell umsetzen können. Um diese Geschwindigkeit zu erreichen, setzen einige Unternehmen auf eine neue Generation von ETL- und Analysetools, die die Zeit für die Erstellung von Berichten drastisch verkürzen. Sie investieren in Software mit Echtzeit-Analysefunktionen, die es ihnen ermöglicht, sofort auf Marktentwicklungen zu reagieren. Aber um die Anwendungen zu entwickeln, zu verwalten und zu betreiben, die Erkenntnisse generieren, brauchen Unternehmen Profis mit spezifischem Fachwissen. Das hat die Nachfrage nach Experten in diesem Bereich in die Höhe getrieben. Um dem Talentmangel zu begegnen, haben Unternehmen eine Reihe von Möglichkeiten. Erstens erhöhen viele ihre Budgets und ihre Rekrutierungs- und Bindungsbemühungen. Zweitens bieten sie ihren derzeitigen Mitarbeitern mehr Ausbildungsmöglichkeiten, um Talente selbst zu entwickeln. Drittens: Viele Unternehmen setzen auf Technologie. Sie kaufen Analyselösungen mit Selbstbedienung und/oder maschineller Lernfähigkeit. Diese Tools wurden entwickelt, um auf einfache Art und Weise verwendet zu werden und Unternehmen dabei zu helfen, ihre Ziele zu erreichen, selbst wenn sie nicht über viele Spezialisten verfügen.

Die Heterogenität der Datensätze führt zu Herausforderungen bei der Integration. Die Informationen stammen von vielen verschiedenen Orten – Unternehmensanwendungen, Social Media Streams, E-Mail-Systeme, von Mitarbeitern erstellten Dokumenten, etc. All diese Daten zu kombinieren und so abzustimmen, dass sie für die Erstellung von Berichten verwendet werden können, kann Probleme verursachen. Hersteller bieten eine Vielzahl von Datenintegrationstools an, die den Prozess vereinfachen sollen. Jedoch beklagen viele Unternehmen, dass sie das Problem der Datenintegration noch nicht gelöst haben. Eng mit der Idee der Datenintegration verbunden ist die Datenvalidierung. Oft bekommen Organisationen ähnliche Daten von verschiedenen Systemen, die aber nicht immer übereinstimmen. Beispielsweise kann das E-Commerce-System Tagesumsätze auf einer bestimmten Ebene anzeigen, während das ERP-System (Enterprise Resource Planning) andere Angaben liefert. Der Prozess, diese Datensätze in Übereinstimmung zu bringen und sicherzustellen, dass sie korrekt, nutzbar und sicher sind, wird als Data Governance bezeichnet. Die Lösung von Data Governance-Herausforderungen ist sehr komplex und erfordert in der Regel eine Kombination aus Richtlinienänderungen und Technologie.

Big Data und Cloud Computing

Das Cloud Computing machte es einfacher, die beste Technologie in kostengünstigen Paketen anzubieten. Cloud Computing senkte nicht nur die Kosten, sondern stellte auch den kleineren Unternehmen eine Vielzahl von Anwendungen zur Verfügung. So wie die Cloud stetig wächst, entsteht auch eine Explosion von Informationen im Internet. Social Media ist eine völlig andere Welt, in der sowohl Vermarkter als auch gewöhnliche Nutzer täglich viele Daten generieren. Organisationen und Institutionen erstellen ebenfalls täglich Daten, die im Laufe der Zeit schwer zu verwalten sind. cloud computing und große Datenmengen bieten gemeinsam eine ideale Lösung, die sowohl skalierbar als auch für Geschäftsanalysen geeignet ist. Die traditionelle Infrastruktur für Datenspeicherung und -verwaltung erweist sich heute als langsamer und schwieriger zu verwalten. Cloud Computing kann ein Unternehmen dagegen mit allen Ressourcen versorgen, die benötigt werden. Vor der Cloud steckten Unternehmen große Summen in den Aufbau von IT-Abteilungen und mussten dann weiter investieren, um die Hardware auf dem neuesten Stand zu halten. Jetzt können Unternehmen Big Data auf externen Servern hosten und zahlen nur für Speicherplatz und Rechenleistung, die sie tatsächlich in Anspruch nehmen (Pay-as-you-go).

Zukunft und Ausblick

Viele Unternehmen werden nach Technologien suchen, die es ihnen ermöglichen, in Echtzeit auf Daten zuzugreifen und zu reagieren. Im Zuge der Fortschritte bei der Datenanalyse haben einige Unternehmen begonnen, in maschinelles Lernen (Machine learning) zu investieren. Machine Learning ist ein Teilgebiet der künstlichen Intelligenz. Durch Erkennen von Mustern in vorliegenden Datenbeständen sind IT-Systeme in der Lage, auf Basis vorhandener Datenbestände und Algorithmen Muster und Gesetzmäßigkeiten zu erkennen und eigenständig Lösungen für Probleme zu entwickeln.

Bildquellen:

- © geralt | pixabay.com

- © geralt | pixabay.com

- © geralt | pixabay.com

- © Tumisu | pixabay.com

- © geralt | pixabay.com